<стр>Исследование Anthropic показывает, что большие языковые модели создают внутренние карты, напоминающие биологическое восприятие, используемое людьми.

Исследователи из Anthropic исследовали способность Claude 3.5 Haiku решать, когда разбить строку текста в пределах фиксированной ширины. Эта задача требует, чтобы модель отслеживала свое положение во время записи. Исследование дало удивительный результат: языковые модели формируют внутренние закономерности, напоминающие пространственное восприятие, которое люди используют для отслеживания местоположения в физическом пространстве.

Андреас Вольпини написал в Твиттере об этой статье и провел аналогию с разделением контента на части для потребления ИИ. В более широком смысле его комментарий работает как метафора того, как и авторы, и модели ориентируются в структуре, находя согласованность на границах, где заканчивается один сегмент и начинается другой.

<п>Однако эта исследовательская статья посвящена не чтению контента, а генерации текста и определению места вставки разрыва строки, чтобы уместить текст в произвольную фиксированную ширину. Целью этого было лучше понять, что происходит внутри LLM, поскольку он отслеживает положение текста, выбор слов и границы разрыва строки во время написания.

<п>Исследователи создали экспериментальную задачу по генерации текста с разрывом строки определенной ширины. Целью было понять, как Claude 3.5 Haiku решает, какие слова должны соответствовать заданной ширине, и когда вставлять разрыв строки, что требовало от модели отслеживания текущей позиции в строке текста, которую она генерирует.

Эксперимент демонстрирует, как языковые модели изучают структуру по шаблонам в тексте без явного программирования или контроля.

Прорыв линии

<п>Задача разрыва строки требует, чтобы модель решила, поместится ли следующее слово в текущую строку или оно должно начинать новую. Чтобы добиться успеха, модель должна изучить ограничение ширины строки (правило, ограничивающее количество символов, которые могут поместиться в строке, как в физическом пространстве на листе бумаги). Для этого LLM должен отслеживать количество написанных символов, подсчитывать, сколько их осталось, и решать, подходит ли следующее слово. Задача требует рассуждения, памяти и планирования. Исследователи использовали графики атрибуции, чтобы визуализировать, как модель координирует эти вычисления, показывая различные внутренние особенности для количества символов, следующего слова и момента, когда требуется разрыв строки.

<ч2>Непрерывный счет

Исследователи заметили, что Claude 3.5 Haiku представляет подсчет символов в строке не как шаг за шагом, а как гладкую геометрическую структуру, которая ведет себя как непрерывно изогнутая поверхность, позволяя модели плавно (на лету) отслеживать положение, а не считать символ за символом.

<п>Что еще интересно, так это то, что они обнаружили, что LLM разработала граничную головку («головку внимания»), которая отвечает за обнаружение границы линии. Механизм внимания взвешивает важность того, что рассматривается (токены). Голова внимания — это специализированный компонент механизма внимания LLM. Пограничная головка, которая является головкой внимания, специализируется на узкой задаче обнаружения конца границы строки.

В исследовательской работе говорится:

“Одной существенной особенностью представления количества символов в строке является то, что “граничный заголовок” искажает представление, позволяя каждому счетчику спариваться с немного большим счетчиком, указывая на то, что граница близка. То есть существует линейная карта QK, которая сдвигает кривую количества символов вдоль себя. Такое действие не допускается вложениями круга или отрезка большой кривизны, подобными тем, которые имеются в построенной нами общей физической модели. Но оно присутствует как в многообразии, которое мы наблюдаем в Хайку, так и, как мы сейчас покажем, в конструкции Фурье. “

Как работает граничное зондирование

Исследователи обнаружили, что Claude 3.5 Haiku определяет, когда строка текста почти достигает конца, путем сравнения двух внутренних сигналов:

<ол>

Сколько символов уже сгенерировано, и Какой длины должна быть линия. <п>Вышеупомянутые главы пограничного внимания решают, на каких частях текста сосредоточить внимание. Некоторые из этих руководителей специализируются на обнаружении момента, когда очередь приближается к своему пределу. Они делают это, слегка поворачивая или выравнивая два внутренних сигнала (количество символов и максимальную ширину строки), так что, когда они почти совпадают, внимание модели переключается на вставку разрыва строки.

Исследователи объясняют:

“Чтобы обнаружить приближающуюся границу строки, модель должна сравнить две величины: текущее количество символов и ширину строки. Мы находим головы внимания, чья матрица QK вращает одно счетное многообразие, чтобы выровнять его с другим с определенным смещением, создавая большой внутренний продукт, когда разница счетов попадает в целевой диапазон. Несколько головок с разными смещениями работают вместе, чтобы точно оценить количество оставшихся символов. “

<ч2>Финальный этап <п>На этом этапе эксперимента модель уже определила, насколько близко она находится к границе строки и какой длины будет следующее слово. Последний шаг — использовать эту информацию.

Вот как это объясняется:

“Последний шаг задачи разрыва строки – объединить оценку границы строки с прогнозом следующего слова, чтобы определить, поместится ли следующее слово в строку или же строка должна быть разорвана.”

<п>Исследователи обнаружили, что определенные внутренние функции модели активируются, когда следующее слово приводит к превышению лимита строки, эффективно выступая в качестве детекторов границ. Когда это происходит, модель увеличивает вероятность предсказания символа новой строки и снижает вероятность предсказания другого слова. Другие функции действуют наоборот: они активируются, когда слово все еще подходит, снижая вероятность вставки разрыва строки.

Вместе эти две силы, одна из которых подталкивает к разрыву строки, а другая сдерживает его, уравновешиваются, чтобы принять решение.

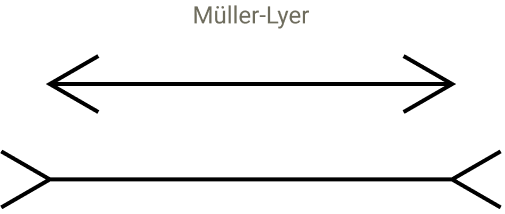

Модели могут иметь визуальные иллюзии?

<стр>Следующая часть исследования просто невероятна, потому что они попытались проверить, может ли модель быть восприимчивой к визуальным иллюзиям, которые могли бы привести к ее сбою. Они начали с идеи о том, как людей можно обмануть с помощью зрительных иллюзий, которые создают ложную перспективу, из-за которой линии одинаковой длины кажутся разной длины, одна короче другой.

Скриншот визуальной иллюзии

<п>

<п>Вставленные искусственные токены исследователей, такие как “@@,” чтобы увидеть, как они нарушили чувство положения модели. Эти тесты вызвали несовпадения во внутренних шаблонах модели, которые она использует для отслеживания положения, подобно визуальным иллюзиям, которые обманывают человеческое восприятие. Это привело к смещению ощущения границ линий модели, показывая, что ее восприятие структуры зависит от контекста и изученных шаблонов. Даже несмотря на то, что LLM не видят, они испытывают искажения в своей внутренней организации, подобно тому, как люди неправильно оценивают то, что они видят, нарушая работу соответствующих головок внимания.

Они объяснили:

“Мы обнаружили, что он модулирует предсказанный следующий токен, нарушая предсказание новой строки! Как и предполагалось, соответствующие заголовки отвлекаются: в то время как в исходной подсказке заголовки следят от новой строки к новой строке, в измененной подсказке заголовки также обращают внимание на @@.”

<п>Они задавались вопросом, есть ли что-то особенное в символах @@ или какие-либо другие случайные символы помешают модели успешно выполнить задачу. Поэтому они провели тест со 180 различными последовательностями и обнаружили, что большинство из них не нарушили способность модели предсказывать точку разрыва строки. Они обнаружили, что только небольшая группа символов, связанных с кодом, могла отвлечь внимание соответствующих голов и нарушить процесс подсчета.

ЛЛМ воспринимают текст как визуальное

Исследование показывает, как текстовые функции превращаются в гладкие геометрические системы внутри языковой модели. Это также показывает, что модели не только обрабатывают символы, но и создают на основе них карты, основанные на восприятии. Эта часть, посвященная восприятию, для меня является тем, что действительно интересно в исследовании. Они продолжают возвращаться к аналогиям, связанным с человеческим восприятием, и к тому, как эти аналогии продолжают вписываться в то, что, по их мнению, происходит внутри LLM. <п>Они пишут: <блоковая цитата><п>“Хотя мы иногда описываем ранние уровни языковых моделей как ответственные за “детокенизацию” вводимых данных, возможно, более выразительно думать об этом как о восприятии. Начало модели действительно отвечает за восприятие входных данных, и большая часть ранних схем служит для восприятия или восприятия текста, подобно тому, как ранние уровни моделей зрения реализуют низкоуровневое восприятие.”

Затем чуть позже пишут:

“Геометрические и алгоритмические закономерности, которые мы наблюдаем, имеют многообещающие параллели с восприятием в биологических нейронных системах. …Эти функции демонстрируют расширение —представляя собой все большее количество символов, активирующихся во все более больших диапазонах —отражая расширение представления чисел в биологическом мозге. Более того, организация признаков на многообразии низкой размерности является примером общего мотива биологического познания. Хотя аналогии не идеальны, мы подозреваем, что все еще существует плодотворное концептуальное совпадение в результате растущего сотрудничества нейробиологии и интерпретируемости.”

Последствия для SEO?

<стр>Артур Кларк писал, что передовые технологии неотличимы от магии. Я думаю, что как только вы поймете технологию, она станет более понятной и менее похожей на волшебство. Не все знания имеют утилитарное применение, и я думаю, что понимание того, как LLM воспринимает контент, полезно в той степени, в которой оно больше не является волшебством. Поможет ли это исследование вам улучшить SEO? Оно углубляет наше понимание того, как языковые модели организуют и интерпретируют структуру контента, делает ее более понятной и менее похожей на волшебство.

<стр>Об исследовании читайте здесь: