Новые данные показывают, что роботы-помощники с искусственным интеллектом увеличили охват сайта, хотя компании резко сократили доступ к ботам для обучения моделей искусственного интеллекта.

Hostinger опубликовал анализ, показывающий, что компании блокируют системы искусственного интеллекта, используемые для обучения больших языковых моделей, в то же время позволяя помощникам искусственного интеллекта продолжать читать и обобщать больше веб-сайтов. Компания изучила 66,7 миллиардов взаимодействий ботов на 5 миллионах веб-сайтов и обнаружила, что сканеры-помощники с искусственным интеллектом, используемые такими инструментами, как ChatGPT, теперь охватывают больше сайтов, даже несмотря на то, что компании ограничивают другие формы доступа к искусственному интеллекту.

Анализ хостинга

<п>Hostinger — это веб-хостинг, а также платформа без кода, управляемая агентами искусственного интеллекта, для построения онлайн-бизнеса. Компания заявила, что проанализировала анонимные журналы веб-сайтов, чтобы измерить, как проверенные сканеры получают доступ к сайтам в масштабе, что позволяет ей сравнивать изменения в том, как поисковые системы и системы искусственного интеллекта извлекают онлайн-контент.

Опубликованный ими анализ показывает, что роботы-помощники с искусственным интеллектом расширили охват веб-сайтов за пятимесячный период. Данные собирались в течение трех шестидневных периодов в июне, августе и ноябре 2025 года.

<п>SearchBot OpenAI увеличил охват сайтов с 52 до 68 процентов, а Applebot (который индексирует контент для обеспечения функций поиска Apple) увеличился вдвое с 17 до 34 процентов. В тот же период традиционные поисковые роботы оставались практически неизменными. Данные показывают, что ИИ-помощники добавляют новый уровень к тому, как информация доходит до пользователей, а не полностью заменяют поисковые системы.

В то же время данные показывают, что компании резко сократили доступ для обучающих роботов ИИ. Доступ к GPTBot OpenAI сократился на 84 процентах веб-сайтов в августе до 12 процентов к ноябрю. Покрытие внешнего агента Meta’s сократилось с 60 процентов до 41 процента. Эти сканеры со временем собирают данные для улучшения моделей ИИ и обновления своих параметрических знаний, но многие компании блокируют их либо для ограничения использования данных, либо из-за опасений нарушения авторских прав.

Знание параметров

Параметрические знания, также известные как параметрическая память, — это информация, которая “жестко закодирована” в модель во время обучения. Это называется “параметрическим” потому что знания хранятся в параметрах модели (весах). Параметрические знания — это долговременная память об сущностях, например, людях, вещах и компаниях.

<п>Когда человек задает LLM вопрос, LLM может распознать объект, например бизнес, а затем извлечь связанные векторы (факты), которые он узнал во время обучения. Таким образом, когда компания или компания блокирует обучающего бота на своем веб-сайте, они не позволяют LLM узнать что-либо о них, что может быть не лучшим решением для организации, которая обеспокоена видимостью ИИ.

Разрешение обучающему боту ИИ сканировать веб-сайт компании позволяет этой компании осуществлять некоторый контроль над тем, что LLM знает о ней, включая то, что она делает, брендинг, все, что находится в «О нас», а также позволяет LLM знать о предлагаемых продуктах или услугах. Информационный сайт может выиграть, если на него будут цитировать ответы.

Бизнес отказывается от параметрических знаний

Анализ Hostinger показывает, что предприятия “агрессивно” блокировка обучающих сканеров ИИ. Хотя в исследовании Hostinger об этом не упоминается, эффект блокировки обучающих ботов ИИ заключается в том, что компании, по сути, отказываются от параметрических знаний LLM, поскольку LLM не может учиться непосредственно на собственном контенте во время обучения, что лишает сайт возможности рассказывать свою собственную историю и вынуждает LLM полагаться на сторонние данные или графики знаний.

Исследования Hostinger показывают:

<блоковая цитата><п>“Основываясь на отслеживании 66,7 миллиардов взаимодействий ботов на 5 миллионах веб-сайтов, компания Hostinger обнаружила существенный парадокс:

Компании активно блокируют обучающих ИИ-ботов — системы, которые собирают контент для создания моделей ИИ. За три месяца доля GPTBot OpenAI упала с 84% до 12% на веб-сайтах.

Однако роботы-помощники с искусственным интеллектом, технологии, которые ChatGPT, Apple и т. д. используют для ответа на вопросы клиентов, быстро расширяются. Доля SearchBot OpenAI выросла с 52% до 68% сайтов; Applebot увеличился вдвое до 34%.”

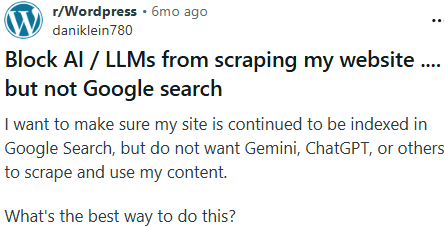

<п>Недавний пост на Reddit показывает, как блокирование доступа LLM к контенту нормализуется и понимается как защита интеллектуальной собственности (IP).

Пост начинается с первого вопроса о том, как заблокировать ИИ:

“Я хочу, чтобы мой сайт продолжал индексироваться в Google Поиске, но не хочу, чтобы Gemini, ChatGPT или другие лица собирали и использовали мой контент.

Как лучше всего это сделать?”

Скриншот разговора на Reddit

<п>

Позже в этой теме кто-то спросил, блокируют ли они LLM для защиты своей интеллектуальной собственности, и оригинальный автор ответил утвердительно, вот и причина.

Человек, начавший обсуждение, ответил:

“Мы публикуем уникальный контент, которого больше нигде нет. LLM часто узнают от нас о вещах в этой крошечной нише. Поэтому нам нужен трафик Google, а не LLM.”

<п>Это может быть уважительной причиной. Сайт, публикующий уникальную учебную информацию о программном продукте, которого больше нет, может захотеть заблокировать LLM от индексации их контента, потому что в противном случае LLM сможет отвечать на вопросы, одновременно устраняя необходимость посещения сайта.

Но для других сайтов с менее уникальным контентом, таких как сайт обзора и сравнения продуктов или сайт электронной коммерции, возможно, это не лучшая стратегия блокировать LLM от добавления информации об этих сайтах в их параметрическую память.

Сообщения о бренде потеряны для LLM

<п>Поскольку помощники искусственного интеллекта отвечают на вопросы напрямую, пользователи могут получать информацию без необходимости посещать веб-сайт. Это может сократить прямой трафик и ограничить доступ к информации о ценах, контексте продукта и сообщениям бренда. Вполне возможно, что путь клиента заканчивается внутри интерфейса искусственного интеллекта, и компании, которые не позволяют LLM получать знания о своих компаниях и предложениях, по сути полагаются на поисковый робот и поисковый индекс, чтобы заполнить этот пробел (и, возможно, это работает?).

Растущее использование ИИ-помощников влияет на маркетинг и распространяется на прогнозирование доходов. Когда системы искусственного интеллекта обобщают предложения и рекомендации, компании, блокирующие LLM, имеют меньше контроля над тем, как появляются цены и ценность. Рекламные усилия теряют заметность на ранних этапах процесса принятия решений, а атрибуция электронной торговли становится сложнее, когда покупки следуют за ответами, сгенерированными ИИ, а не за прямыми посещениями сайта.

По словам Hostinger, некоторые организации становятся более избирательными в отношении того, какой контент доступен ИИ, особенно ИИ-помощникам.

Томас Расимас, руководитель отдела искусственного интеллекта Hostinger, прокомментировал:

“Поскольку ИИ-помощники все чаще отвечают на вопросы напрямую, Интернет переходит от модели, основанной на кликах, к модели, опосредованной агентами. Реальный риск для бизнеса заключается не в самом доступе к ИИ, а в потере контроля над тем, как ценообразование, позиционирование и ценность представляются при принятии решений.”

<ч2>На вынос

Блокирование LLM от использования данных веб-сайта для обучения на самом деле не является позицией по умолчанию, даже несмотря на то, что многие люди испытывают настоящий гнев и раздражение от идеи обучения LLM их контенту. Возможно, будет полезно принять более взвешенный ответ, взвесив преимущества и недостатки, а также рассмотреть, являются ли эти недостатки реальными или предполагаемыми.