Search Console — фантастический бесплатный инструмент, но у него есть довольно серьезные ограничения на данные и индексирование. Вот как можно заставить его работать тяжелее.

<сильный>TL;DR

<ол>

<ли>Все это позволяет значительно расширить индексацию, запросы и анализ на уровне страниц. Все бесплатно. Особенно, если вы используете ограничение индексации URL-адресов API в 2000 на каждое свойство.

Изображение предоставлено: Гарри Кларксон-Беннетт

Это в основном применимо к корпоративным сайтам. Сайты с глубокой структурой подпапок и богатой историей публикации большого количества контента. Технически это не зависит от издателя. Если вы работаете в интернет-магазине, это тоже будет невероятно полезно.

Я и он одинаково любим все большие и неуклюжие сайты.

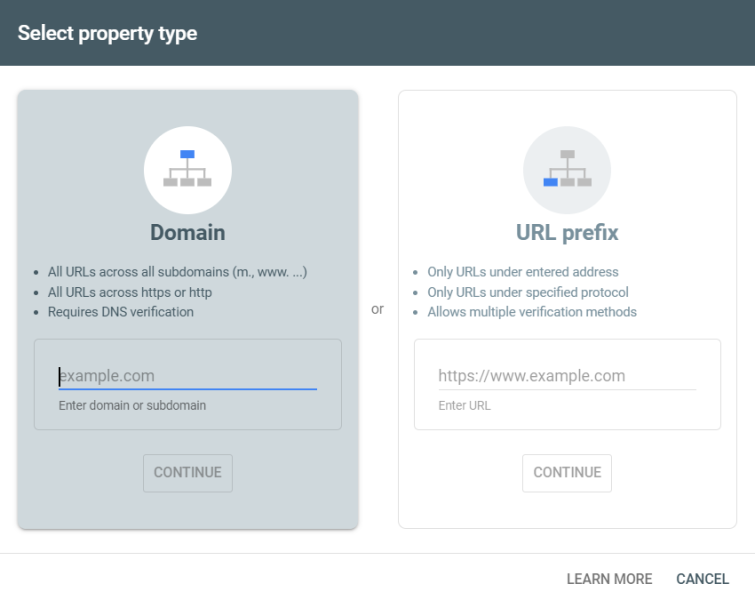

Что такое свойство Search Console?

Вы можете настроить свойства на уровне домена или на уровне префикса URL (Изображение предоставлено Гарри Кларксоном-Беннеттом)

Если вы только что настроили ресурс на уровне домена, вы все равно получите доступ ко всем полезным функциям, которые предлагает GSC. Данные о кликах и показах, анализ индексации и отчет о статистике сканирования (доступен только в ресурсах на уровне домена) и это лишь некоторые из них. Но вас сдерживают некоторые довольно серьезные ограничения:

<ул>

<п>Хотя 16-месячный лимит и выборочные данные по ключевым словам требуют от вас экспорта данных в BigQuery (или использования одного из инструментов ниже), вы можете значительно улучшить работу с GSC, более эффективно используя свойства.

Существует несколько методов проверки – Проверка DNS, HTML-тег или загрузка файла, код отслеживания Google Analytics. После того как вы настроили и подтвердили ресурс уровня домена, вы можете добавить любой ресурс дочернего уровня. Поддомены и подпапки одинаково.

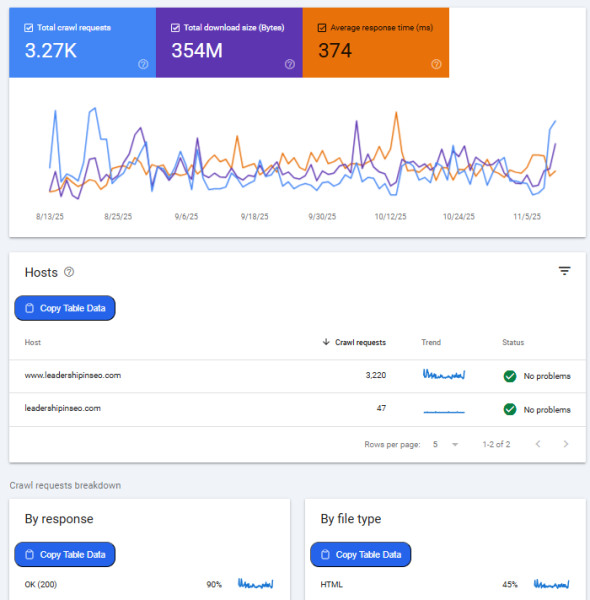

Отчет о статистике сканирования может быть настоящей золотой жилой, особенно для крупных сайтов (не этого!) (Изображение предоставлено: Гарри Кларксон-Беннетт) <п>Отчет о статистике сканирования может быть чрезвычайно полезен для устранения проблем, таких как всплески URL-адресов параметров или несанкционированные поддомены. Особенно на крупных сайтах, где отделы делают что-то, о чем мы с вами не узнаем, пока не станет слишком поздно.

Но, разбивая изменения на уровне хоста, типа файла и кода ответа, вы можете остановить работу в источнике. Легко выявляйте проблемы, влияющие на ваш краулинговый бюджет, прежде чем вы захотите поразить кого-то своим подходом к внутренним ссылкам и URL-адресам параметров.

Во всяком случае, обычно. Иногда людям просто нужен хороший комочек. Образно говоря, конечно.

Субдомены обычно рассматриваются как отдельные объекты со своим собственным бюджетом на сканирование. Однако это не всегда так. По словам Джона Мюллера, вполне возможно, что Google может сгруппировать ваши поддомены вместе для целей краулингового бюджета.

По словам Гэри Иллиеса, бюджет сканирования обычно задается именем хоста. Таким образом, поддомены должны иметь свой собственный бюджет сканирования, если имя хоста отделено от основного домена.

Как определить правильные свойства?

<п>Ваша работа как SEO-специалиста — знать веб-сайт лучше, чем кто-либо другой. В большинстве случаев это не так уж сложно, потому что вы работаете с цифровыми невеждами. Обычно эти данные можно найти в GSC. Но более крупным сайтам нужно немного больше любви.

Сканируйте свой сайт с помощью Screaming Frog, Sitebulb, художника, ранее известного как Deepcrawl, и создайте картину структуры вашего сайта, если вы еще этого не знаете. Сначала добавьте наиболее ценные свойства (сначала доход, потом трафик) и работайте исходя из этого.

Некоторые альтернативы GSC

<п>Прежде чем идти дальше, с моей стороны было бы упущением не упомянуть некоторые отличные альтернативы GSC. Альтернативы, которые полностью снимают для вас эти ограничения.

SEO-стек

Дэниел много говорил о подсчете запросов, и это фантастический способ понять, в каком направлении движется ваш сайт или контент в поиске. Поднимаясь на первые 3 или 10 позиций – хороший. Спускаемся туда и вверх дальше вниз – плохо. <ч3>SEO получает

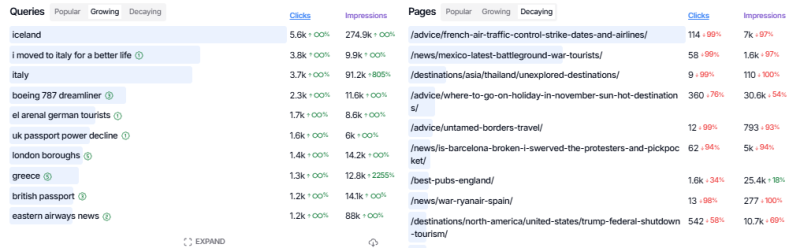

Растущие и разрушающиеся страницы и запросы в SEO Gets очень полезны (Изображение предоставлено: Гарри Кларксон-Беннетт)

Создавайте группы ключевых слов и страниц для подсчета запросов и анализа кликов и показов на уровне кластера контента. SEO Gets, возможно, имеет лучшую бесплатную версию среди всех инструментов на рынке.

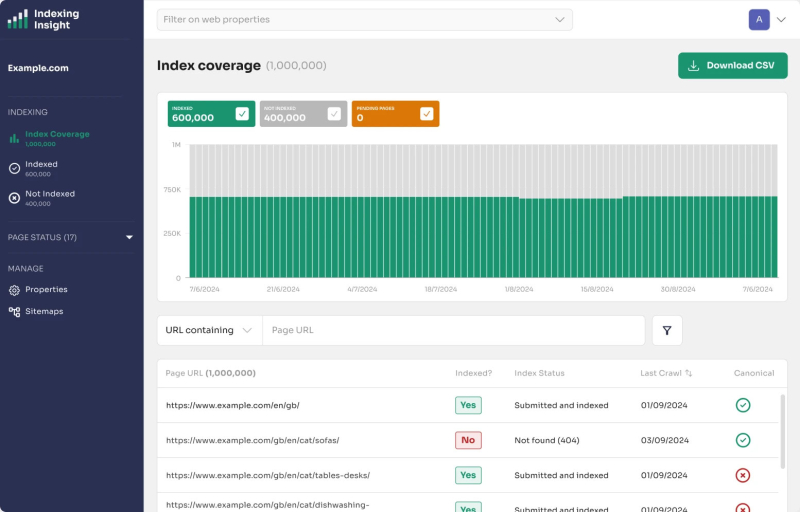

Инсайт по индексированию

<п>С отличными визуализациями и точками данных (знаете ли вы, что если URL-адрес не сканировался в течение 130 дней, он выпадает из индекса ?), вам нужно такое решение. Особенно на устаревших и корпоративных сайтах.

Удалите ограничение индексации в 2000 URL-адресов в день с помощью API и ограничение URL-адреса в 1000 строк (Изображение предоставлено Гарри Кларксон-Беннеттом)

Все эти инструменты мгновенно улучшают работу с Search Console.

<х2>Преимущества подхода с участием нескольких объектов

Возможно, самый эффективный способ обойти некоторые из вышеупомянутых проблем — это масштабировать количество принадлежащих вам объектов недвижимости. По двум основным причинам – это бесплатно и позволяет обойти основные ограничения API.

<п>Все любят бесплатные вещи. Однажды я проходил мимо агента новостей, проводившего акцию в день открытия, где раздавали банки с нарезанными помидорами. Это было странно. Еще более странно то, что там была очередь. Очередь, к которой я присоединился.

<с>Спагетти болоньезе еще никогда не были такими сладкими.

Детальное отслеживание индексации

Возможно, одной из лучших, но наиболее ограничивающих функций Search Console является анализ индексации. Понимание различий между сканированием – В настоящее время не проиндексировано и обнаружено – Информация «В настоящее время не проиндексировано» может помочь вам принять разумные решения, которые повысят эффективность вашего сайта. Значительное улучшение вашего краулингового бюджета и стратегий внутренних ссылок.

Изображение предоставлено: Гарри Кларксон-Беннетт

Страницы, находящиеся в просканированных – В настоящее время не индексированныйконвейер может не требовать каких-либо немедленных действий. Страница была просканирована, но не была признана подходящей для индекса Google. Это может означать проблемы с качеством страницы, поэтому стоит убедиться, что ваш контент повышает ценность, а ваши внутренние ссылки отдают приоритет важным страницам.

<сильный>Обнаружено – В настоящее время не индексируется немного отличается. Это означает, что Google нашел URL-адрес, но еще не просканировал его. Возможно, вывод вашего контента не совсем соответствует ценности вашего сайта, которую оценивает Google. Или что ваша внутренняя структура ссылок должна лучше расставлять приоритеты важного контента. Или какая-то техническая проблема на сервере.

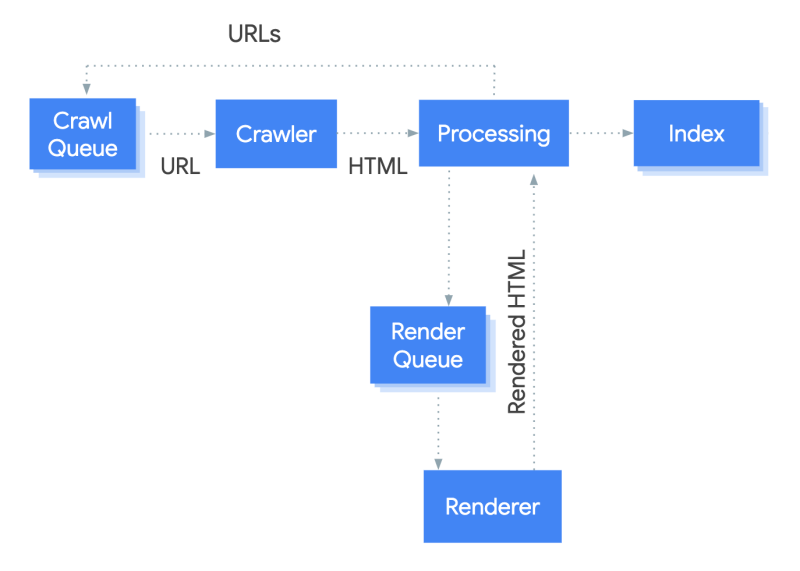

<п>Все это требует хотя бы элементарного понимания того, как работает конвейер индексации Google. Это не бинарный подход. Гэри Иллис сказал, что у Google есть многоуровневая система индексации. Контент, который необходимо обслуживать чаще, хранится в более качественной и дорогой системе. Менее ценный контент хранится в менее дорогой системе.

Как работает система сканирования и рендеринга Google (Изображение предоставлено Гарри Кларксоном-Беннеттом)

Меньше обезьяна видит, обезьяна делает; Больше обезьян видят, обезьяны принимают решения на основе ценности сайта, бюджета сканирования, эффективности, загрузки сервера и использования JavaScript.

При многоуровневом подходе к индексации приоритет отдается воспринимаемой ценности и необработанному HTML-коду страницы. JavaScript ставится в очередь, потому что он гораздо более ресурсоемок. Вот почему оптимизаторы беспокоятся о том, чтобы ваш контент отображался на стороне сервера.

<стр>У Адама есть очень хорошее руководство по типам неиндексируемых страниц в GSC и тому, что они здесь означают. <блоковая цитата><п>Стоит отметить, что инструмент индексации страниц не полностью обновлен. Я думаю, что он обновляется пару раз в неделю. Но я не могу вспомнить, откуда я взял эту информацию, так что не заставляйте меня это делать…

Если вы крупный издатель новостей, вы увидите множество новостей в разделе «Сканируемый контент» – Категория «В настоящее время не индексируется». Но когда вы проверяете URL-адрес (что вам обязательно следует сделать), он может быть проиндексирован. Есть задержка.

Масштабируемость API индексирования

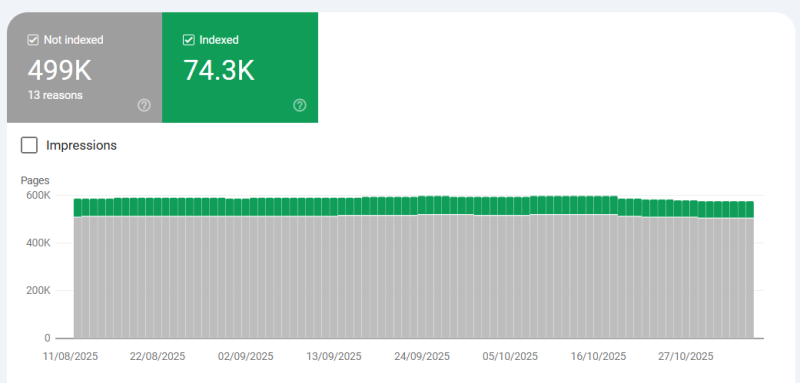

<п>Когда вы начинаете работать над более крупными веб-сайтами – и я говорю о веб-сайтах, вложенные папки которых содержат более 500 000 страниц – Ограничение API на 2000 URL-адресов становится очевидным. Вы просто не можете эффективно идентифицировать страницы, которые попадают и выходят из списка “Почему страницы не индексируются?” секция.

Не очень хорошо, видели и хуже (Изображение предоставлено Гарри Кларксоном-Беннеттом)

Но когда вы настраиваете несколько свойств, вы можете эффективно масштабировать.

Ограничение в 2000 применяется только на уровне собственности. Таким образом, если вы настроите ресурс на уровне домена вместе с 20 другими свойствами (на уровне подпапки), вы сможете использовать до 42 000 URL-адресов в день. Чем больше вы делаете, тем лучше.

И у API есть и другие преимущества:

Но это не гарантирует индексацию. Это просьба, а не команда.

Чтобы настроить его, вам необходимо включить API в Google Cloud Console. Вы можете следовать этому полуполезному краткому руководству. Это не весело. Это заноза в заднице. Но оно того стоит. Затем вам понадобится скрипт Python для отправки запросов API и мониторинга квот и ответов API (2xx, 3xx, 4xx и т. д.).

<п>Если вы хотите пофантазировать, вы можете объединить их с данными о публикации, чтобы точно определить, сколько времени требуется страницам в определенных разделах для индексации. И вам всегда следует хотеть пофантазировать.

Это действительно хороший сигнал о том, какие ваши подпапки являются наиболее важными с точки зрения Google. Категории с высокими и неэффективными показателями.

Детализация данных о кликах и показах

Необходимо для больших сайтов. Консоль поиска по умолчанию не только хранит только 1000 строк или данных запросов и URL-адресов, но и хранит их только в течение 16 месяцев. Хотя это звучит как долгий срок, перенесемся на год или два вперед, и вы пожалеете, что не начали хранить данные в BigQuery.

Особенно, когда дело доходит до анализа поведения кликов в годовом исчислении и планирования мероприятий. Один лишь скрежет зубов окупит ежегодную поездку вашего стоматолога на Арубу. <п>Но, безусловно, самый простой способ просмотреть данные поиска на более детальном уровне — это создать больше свойств GSC. Хотя у вас все еще те же ограничения на запросы и URL-адреса, поскольку у вас есть несколько свойств вместо одного, ограничения на данные становятся гораздо менее ограничивающими.

А как насчет файлов Sitemap?

Не имеет прямого отношения к индексации GSC, но следует отметить. Файлы Sitemap не являются особенно сильным инструментом в вашем арсенале, когда дело доходит до индексации контента. Индексация контента зависит от того, насколько он “полезен для пользователей.

С моей стороны было бы упущением не подчеркнуть, что карты сайта новостей немного отличаются. Когда скорость публикации и индексация так важны, вы хотите разместить свои самые свежие статьи в проверенном месте.

<п>В конечном итоге все сводится к Navboost. Хорошие и плохие клики и последний самый длинный клик. Или, если говорить больше о новостях, Glue – огромная таблица взаимодействия с пользователем, предназначенная для ранжирования свежего контента в режиме реального времени и поддержания индекса динамического. Индексация обусловлена тем, что ваш контент достаточно ценен для пользователей, чтобы Google мог продолжать хранить его в своем индексе.

Glue подчеркивает сигналы немедленного взаимодействия, такие как наведение и смахивание, для более мгновенной обратной связи (Изображение предоставлено: Гарри) Кларксон-Беннетт) <п>Благодаря многолетнему опыту (и подтверждению через судебное разбирательство Министерства юстиции и утечку Google) мы знаем, что авторитет вашего сайта (Q*), влияние с течением времени и структура внутренних ссылок играют ключевую роль. Но как только он проиндексирован, все зависит от вовлеченности пользователей. Карта сайта или ее отсутствие, вы не сможете заставить людей полюбить ваш бежевый, унылый контент.

И индексы карты сайта?

Большинство крупных сайтов используют индексы карты сайта. По сути, это карта сайта для управления более крупными веб-сайтами, превышающими ограничение в 50 000 строк. Загружая индекс карты сайта в Search Console, не останавливайтесь на достигнутом. Загрузите каждую отдельную карту сайта в свой индекс карты сайта.

Это дает вам доступ к индексации на уровне карты сайта в отчете об индексировании страниц или картах сайта. То, чем гораздо сложнее управлять, когда у вас миллионы страниц в индексе карты сайта.

Просмотр данных на уровне карты сайта дает более подробные данные индексации в GSC (Изображение предоставлено: Гарри Кларксон-Беннетт)

Примените тот же подход к картам сайта, который мы обсуждали с свойствами. Чем больше, тем лучше.

Стоит знать, что каждому документу также присваивается a DocID. DocID хранит сигналы для оценки популярности страницы: клики пользователей, ее качество и авторитетность, данные сканирования и рейтинг спама, среди прочего.

Все, что считается критически важным для ранжирования страницы, сохраняется и используется для целей индексации и ранжирования.

Что мне делать дальше?

<ол>

В конечном счете, Search Console очень полезна. Но у него есть существенные ограничения, и, честно говоря, он бесплатен. Другие инструменты превзошли его во многих отношениях. Но, по крайней мере, вам следует заставить его работать как можно усерднее. r

Этот пост был первоначально опубликован на сайте Leadership in SEO.