<стр>Взгляд на обещания, риски и колебания платформы.

<п>На недавней конференции меня спросили, имеет ли значение llms.txt. Лично я не фанат, и ниже мы объясним почему. Я послушал подругу, которая сказала мне, что мне нужно узнать об этом больше, поскольку она считала, что я не полностью понял это предложение, и я должен признать, что она была права. После более глубокого изучения этого вопроса я теперь понимаю это гораздо лучше. К сожалению, это лишь укрепило мои первоначальные опасения. И хотя это может звучать так, будто идея не нравится одному человеку, на самом деле я пытаюсь взглянуть на это с точки зрения поисковой системы или платформы искусственного интеллекта. Почему бы им или почему бы им не принять этот протокол? И эта точка зрения привела меня к некоторым, я думаю, интересным выводам.

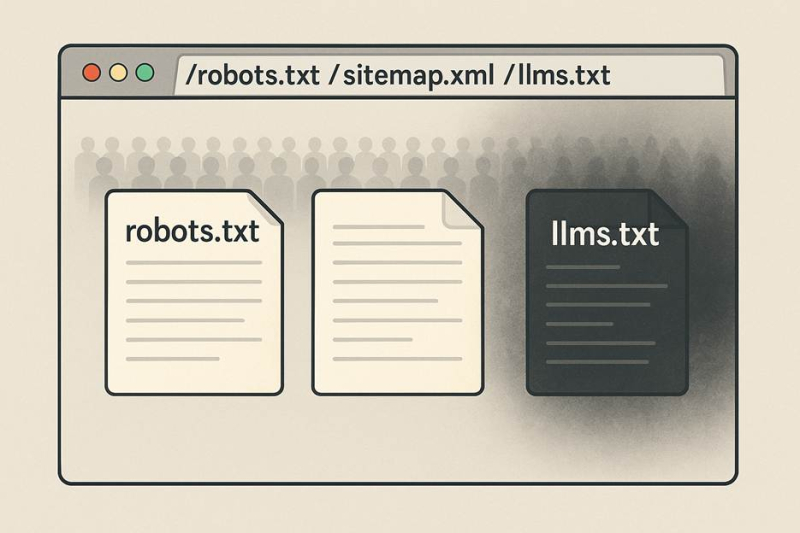

<п>Мы все знаем, что поиск больше не является единственным уровнем обнаружения. Инструменты на основе моделей большого языка (LLM) меняют способы поиска, потребления и представления веб-контента. Предлагаемый протокол под названием llms.txt призван помочь веб-сайтам управлять этими инструментами. Но эта идея несет в себе те же проблемы с доверием, которые убили ранее «помочь машине понять меня»; сигналы. В этой статье рассматривается, для чего предназначен файл llms.txt (насколько я это понимаю), почему платформы будут этому сопротивляться, как им можно злоупотреблять и что необходимо изменить, прежде чем он станет значимым.

Изображение предоставлено: Дуэйн Форрестер

Что llms.txt надеялся исправить

Современные веб-сайты созданы для браузеров людей: тяжелый JavaScript, сложная навигация, межстраничные объявления, реклама, динамические шаблоны. Но большинство LLM, особенно во время вывода, работают в ограниченных средах: ограниченные контекстные окна, однопроходное чтение документов и более простой поиск, чем традиционные поисковые индексаторы. Исходное предложение от Answer.AI предлагает добавить файл llms.txt markdown в корень сайта, в котором перечислены наиболее важные страницы, при необходимости со сглаженным контентом, чтобы системам ИИ не приходилось бороться с шумом.

Сторонники описывают файл как “созданную вручную карту сайта для инструментов искусственного интеллекта” а не файл блокировки сканирования. Короче говоря, теория: представляйте наиболее ценный контент вашего сайта в более чистом и доступном формате, чтобы инструменты не пропустили его или неправильно истолковали.

Проблема доверия, которая никогда не умирает

<п>Если вы сделаете шаг назад, вы обнаружите, что это знакомая закономерность. В начале истории Интернета что-то вроде мета-тега ключевых слов позволяло сайту заявить, о чем он; им широко злоупотребляли и в конечном итоге игнорировали. Точно так же разметка авторства (rel=author и т. д.) пыталась помочь машинам понять авторитет, и снова последовали манипуляции. Структурированные данные (schema.org) добились успеха только после многих лет управления и совместного внедрения поисковыми системами. llms.txt находится прямо внутри этой линии: самопровозглашенный сигнал, который обещает ясность, но доверяет издателю говорить правду. Без проверки каждый маленький стандарт корневого файла становится вектором манипуляций.

<х2>Книга о злоупотреблениях (что сразу видят спам-команды)

Что касается групп по политике платформы, все ясно: если веб-сайт публикует файл с именем llms.txt и заявляет все, что ему нравится, как платформа узнает, что то, что указано в списке, соответствует реальному контенту, который видят пользователи, или ему можно доверять в любом случае? Открывается несколько путей эксплойта:

<ол>

Более широкий комментарий отмечает этот риск. Например, некоторые отраслевые обозреватели утверждают, что файл llms.txt «создает возможности для злоупотреблений, таких как маскировка». И отзывы сообщества, по-видимому, подтверждают минимальное фактическое понимание: «Ни один LLM их не читает». По иронии судьбы, отсутствие использования означает меньше реальных примеров злоупотреблений, но это также означает, что было протестировано меньше механизмов безопасности.

Почему платформы колеблются

С точки зрения платформы расчет прагматичен: новые сигналы увеличивают стоимость, риск и бремя обеспечения соблюдения требований. Вот как работает логика.

Во-первых,<сильное>качество сигнала. Если записи в файле llms.txt содержат шум, содержат спам или не соответствуют действующему сайту, доверие к ним может снизить, а не повысить качество контента. Платформы должны задаться вопросом: улучшит ли этот файл точность ответов нашей модели или создаст ли риск дезинформации или манипуляций?

Второй,<сильный>стоимость проверки. Чтобы доверять манифесту, вам необходимо перекрестно проверить его на соответствие живому HTML, каноническим тегам, структурированным данным, журналам сайта и т. д. Это требует ресурсов. Без проверки манифест — это просто еще один список, который может лгать.

Третий, <сильный>борьба со злоупотреблениями. Если злоумышленник публикует манифест llms.txt, в котором перечислены вводящие в заблуждение URL-адреса, которые получает LLM, кто устраняет последствия? Владелец сайта? Платформа искусственного интеллекта? Поставщик модели? Эта проблема ответственности реальна.

Четвёртый, <сильный>риск причинения вреда пользователю. LLM, цитирующий содержание манифеста, может дать неточные или предвзятые ответы. Это только усугубляет текущую проблему, с которой мы уже сталкиваемся, связанную с неточными ответами и людьми, которые следуют неправильным, неправильным или опасным ответам.

Google уже заявил что это будет а не полагайтесь на llms.txt для своих “Обзоров искусственного интеллекта” и продолжает следовать “нормальному SEO.” А Джон Мюллер написал: «Наверное, ни одна система искусственного интеллекта в настоящее время не использует llms.txt». Таким образом, инструменты, которые могли бы использовать манифест, по большей части остаются в стороне. Это отражает идею о том, что стандарт корневого файла без установленного доверия является обузой.

Почему принятие без управления терпит неудачу

Каждый успешный веб-стандарт имеет общую ДНК: руководящий орган, четкий словарный запас и пути обеспечения соблюдения. Все выжившие стандарты отвечают на один вопрос заранее … “Кто владеет правилами?”

<п>Schema.org сработал, потому что ответ был ясен. Все началось как коалиция Bing, Google, Yahoo и Яндекс. Сотрудничество определяет ограниченный словарь, согласованный синтаксис и обратную связь с издателями. Когда возникали злоупотребления (фейковые отзывы, фейковые данные о продуктах), эти системы координировали правоприменение и уточняли документацию. Сигнал сохранился, потому что он не принадлежал ни одной компании и не был оставлен на самоконтроль.

Robots.txt, напротив, выжил, будучи минимальным. Он не пытался описать качество или семантику контента. Он только сообщал сканерам, что не прикасаться. Эта простота уменьшила площадь поверхности для злоупотреблений. Это практически не требовало доверия между веб-мастерами и платформами. Худшее, что могло случиться, — это чрезмерная блокировка вашего собственного контента; не было никакого стимула лежать внутри файла.

llms.txt живет в противоположном мире. Он предлагает издателям самостоятельно заявить о том, что важнее всего, и, в полнотекстовом варианте, о том, в чем заключается “правда” этого контента. Не существует ни консорциума, контролирующего формат, ни стандартизированной схемы, на которую можно было бы валидировать, ни группы контроля, которая бы проверяла злоупотребления. Опубликовать его может любой желающий. Никто не обязан это уважать. И сегодня известно, что ни один крупный поставщик LLM не использует его в производстве. Возможно, в частном порядке, но публично, они не делают никаких заявлений об усыновлении.

Что нужно изменить, чтобы доверие укрепилось

<п>Чтобы перейти от необязательной четкой идеи к действительно надежному сигналу, необходимо выполнить несколько условий, и каждое из них влечет за собой затраты либо в долларах, либо в человеческом времени, то есть снова в долларах.

<ул>

Настоящая ценность сегодня

Для владельцев сайтов файл llms.txt по-прежнему может иметь некоторую ценность, но не как гарантированный путь к трафику или «рейтинг AI». Он может функционировать как инструмент выравнивания контента, помогая внутренним командам определять приоритетные URL-адреса, которые вы хотите, чтобы системы ИИ видели. Для сайтов с большим количеством документации, внутренних агентских систем или партнерских инструментов, которыми вы управляете, может иметь смысл опубликовать манифест и провести эксперимент.

Однако, если ваша цель состоит в том, чтобы повлиять на крупные публичные результаты, основанные на LLM (например, Google, OpenAI или Perplexity), вам следует действовать осторожно. Пока нет публичных доказательств того, что системы соблюдают llms.txt. Другими словами: относитесь к llms.txt как к «зеркалу»; вашей контент-стратегии, а не “магнит” перетягивание трафика. Конечно, это означает создание файла(ов) и их поддержку, поэтому учитывайте добавленную работу и ту прибыль, которую, по вашему мнению, вы получите.

<ч2>Заключительные мысли

Сеть продолжает пытаться обучать машины самой себе. Каждое поколение изобретает новый формат, новый способ заявить: «вот что важно». И каждый раз ее судьбу решает один и тот же вопрос: “Можно ли доверять этому сигналу?” Идея llms.txt здравая, но механизмы доверия еще не встроены. Пока не появятся проверка, управление и эмпирические доказательства, llms.txt будет находиться в серой зоне между обещанием и проблемой.

Этот пост был первоначально опубликован на сайте Duane Forrester Decodes.