Гэри Иллис из Google подчеркивает устойчивость к ошибкам и неожиданные особенности файла robots.txt, поскольку он отмечает 30-летие поддержки сканирования веб-страниц и поисковой оптимизации.

- Проверьте файл robots.txt: убедитесь, что он содержит только необходимые директивы и не содержит потенциальных ошибок или неправильных конфигураций.

- Будьте осторожны с правописанием: хотя анализаторы могут игнорировать орфографические ошибки, это может привести к непреднамеренному поведению при сканировании.

- Используйте комментарии к строкам: комментарии можно использовать для документирования файла robots.txt для дальнейшего использования.

- Проверьте файл robots.txt: убедитесь, что он содержит только необходимые директивы и не содержит потенциальных ошибок или неправильных конфигураций.

- Будьте осторожны с правописанием: хотя парсеры могут игнорировать орфографические ошибки, это может привести к непреднамеренному сканированию.

- Используйте комментарии к строкам: комментарии можно использовать для документирования файла robots.txt для дальнейшего использования.

В недавнем посте на LinkedIn Гэри Иллис, аналитик Google, освещает менее известные аспекты файла robots.txt, поскольку ему исполняется 30 лет.

<п>Файл robots.txt, компонент сканирования и индексирования веб-страниц, был основой практики SEO с момента его создания.

<стр>Вот одна из причин, почему он остаётся полезным.

Надежная обработка ошибок

Иллиес подчеркивает устойчивость файла к ошибкам.

“robots.txt практически не содержит ошибок”, заявил Иллиес.

В своем посте он объяснил, что парсеры robots.txt предназначены для игнорирования большинства ошибок без ущерба для функциональности.

<п>Это означает, что файл продолжит работу, даже если вы случайно включите несвязанный контент или напишете директивы с ошибками.

Он пояснил, что парсеры обычно распознают и обрабатывают ключевые директивы, такие как user-agent,allow и disallow, пропуская при этом нераспознанный контент.

Неожиданная особенность: линейные команды

Иллиес указал на наличие строковых комментариев в файлах robots.txt, что вызвало у него недоумение, учитывая толерантность файла к ошибкам.

Он предложил SEO-сообществу порассуждать о причинах этого включения.

Ответы на Illyes’ Сообщение

Ответ SEO-сообщества на Иллиеса; Сообщение предоставляет дополнительный контекст о практическом значении устойчивости к ошибкам в robots.txt и использовании строковых комментариев.

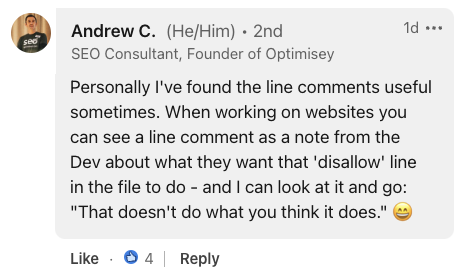

Эндрю К., основатель Optimisey, подчеркнул полезность строковых комментариев для внутреннего общения, заявив:

“При работе с веб-сайтами вы можете увидеть комментарий к строке в виде примечания от разработчика о том, чего он хочет от ‘disallow’ строку в файле, которую нужно сделать.”

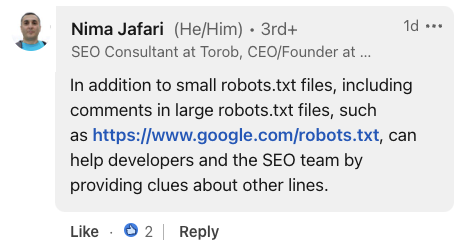

Снимок экрана из LinkedIn, июль 2024 г. <стр>Нима Джафари, консультант по SEO, подчеркивает ценность комментариев в крупномасштабных реализациях. <п>Он отметил, что для обширных файлов robots.txt комментарии могут «помогать разработчикам и команде SEO, предоставляя подсказки о других строках».

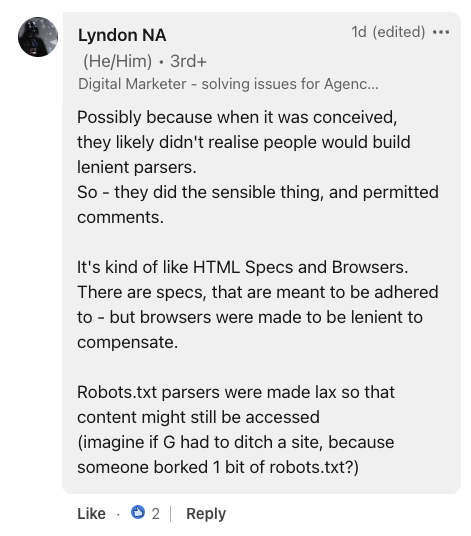

Снимок экрана из LinkedIn, июль 2024 г. <стр> Предоставляя исторический контекст, Линдон Н.А., специалист по цифровому маркетингу, сравнил robots.txt со спецификациями HTML и браузерами.

<п>Он предположил, что устойчивость файла к ошибкам, вероятно, была преднамеренным выбором дизайна, заявив:

“Парсеры Robots.txt были сделаны слабыми, чтобы к контенту все равно можно было получить доступ (представьте, если бы G пришлось отказаться от сайта, потому что кто-то испортил 1 бит robots. txt?).”

Снимок экрана из LinkedIn, июль 2024 г.

Почему SEJ заботится

Понимание нюансов файла robots.txt поможет вам лучше оптимизировать сайты.

Хотя толерантность к ошибкам файла в целом полезна, она потенциально может привести к упущенным из виду проблемам, если не соблюдать осторожность.

Что делать с этой информацией

<ол>