<стр>Начните с BigQuery для анализа контента с использованием данных Google Search Console. Предоставляются советы, подсказки, лучшие практики и вопросы. <п> <изображение fetchpriority="высокий" src="https://www.searchenginejournal.com/wp-content/uploads/2024/02/Big-Query-and-GSC-data-for-content-Performance-anaанализ-760x400.png" ширина = "760" высота="400" alt="Как использовать данные больших запросов и GSC для анализа эффективности контента" srcset="https://www.searchenginejournal.com/wp-content/uploads/2024/02/Big-Query-and-GSC-data-for-content- Performance-anaанализ-1520x800.png 1,5x" />

Если вы всегда восхищались людьми, использующими Google Search Console API для интересных вещей, эта статья будет для вас полезным чтением.

Вы можете использовать BigQuery с массовым экспортом данных GSC, чтобы получить те же преимущества, не прибегая к помощи разработчика.

<п>С помощью BigQuery вы можете эффективно анализировать большие объемы данных при массовом экспорте данных GSC.

У вас не будет возможности получения данных в реальном времени; в нашем сценарии это доступно через API, но вы можете рассчитывать на ежедневный импорт данных, что означает, что вы работаете с актуальной информацией.

Используя BigQuery и экспорт массовых данных GSC, вы получаете доступ к комплексным данным поисковой аналитики – – это та часть, о которой все восторгаются в LinkedIn.

<п>По словам Гаса Пелогии, менеджера по продуктам SEO в Indeed:

“Это меняет правила игры и дает прекрасную возможность изучить SQL. Наконец-то мы можем обойти ограничения GSC и внешних инструментов SEO. Я был удивлен, увидев, насколько просто было получить данные.”

Структурированный подход к использованию данных BigQuery и Google Search Console (GSC) для анализа эффективности контента

Цель этой статьи не состоит в том, чтобы предоставить вам длинный список вопросов или обширный пошаговый план того, как провести самый интенсивный аудит всех времен.

Я хочу, чтобы вы чувствовали себя более комфортно при анализе данных без ограничений, присущих интерфейсу консоли поиска Google. Для этого вам необходимо продумать пять шагов:

<ул>

Проблема, с которой мы часто сталкиваемся при начале работы с BigQuery, заключается в том, что мы все хотим немедленно запросить данные. Но этого недостаточно.

Истинная ценность, которую вы можете принести, — это структурированный подход к анализу данных.

<х2>1. Определить варианты использования

Часто рекомендуется ознакомиться со своими данными, прежде чем решить, что вы хотите анализировать. Хотя это и правда, в данном случае это будет вас ограничивать.

<стр>Рекомендуем начать с определения конкретной цели и задач анализа эффективности контента.

Сценарий №1: Определите запросы и страницы, которые приносят больше всего кликов

<блоковая цитата><п>«Я считаю, что каждый качественный SEO-аудит должен также анализировать видимость и эффективность сайта в поиске. Как только вы определите эти области, вы будете знать, на чем следует сосредоточиться в своих рекомендациях по аудиту.”

Сказала Ольга Зарр в своей статье «Как проверить сайт с помощью Google Search Console». руководство.

Для этого вам нужны запросы и — страницы, которые приносят наибольшее количество кликов.

Сценарий №2: расчет UQC

<стр>Если вы хотите выявить слабые места или возможности, подсчет количества уникальных запросов (UQC) на странице даст ценную информацию. <п>Вы уже знаете это, потому что используете этот тип анализа в таких инструментах SEO, как Semrush, SE Ranking, Dragon Metrics или Serpstat (у последнего есть отличное руководство «Как использовать консоль поиска Google для создания контент-планов»).

Однако невероятно полезно воссоздать это с помощью собственных данных Google Search Console. Вы можете автоматизировать и регулярно повторять этот процесс.

В этом есть свои преимущества:

<ул>

<ли>Анализ UQC на странице также может выявить, какие полосы позиций (например, позиции 1–3, 4–10 и т. д.) демонстрируют большую вариативность с точки зрения количества уникальных запросов. Это может помочь расставить приоритеты в усилиях по оптимизации.

<х3>Вариант использования №3: Оценка риска контента

<стр>Джесс Джойс, B2B &amp;amp;amp;amp;amp;amp;amp;amp;amp;amp;B2B; SaaS-эксперт по SEO имеет приносящую доход структуру оптимизации контента, которой она делится с клиентами.

Одним из важнейших шагов является поиск страниц, на которых наблюдалось снижение количества кликов и показов квартал за кварталом. Для этого она полагается на данные Search Console.

Построить этот запрос было бы здорово, но прежде чем мы перейдем к этому, нам нужно оценить риск контента.

Если вы подсчитаете процент от общего числа кликов, полученный 1% верхних страниц веб-сайта, на основе количества кликов, полученных каждой страницей, вы сможете быстро определить, находитесь ли вы в опасной зоне &ndash ; это означает, что существуют потенциальные риски, связанные с чрезмерным использованием небольшого подмножества страниц.

Вот почему это важно:

<ул>

<х2>2. Определите соответствующие показатели <п>Анализ вашего контента позволяет вам определить, какой контент эффективен, а какой нет, что дает вам возможность принимать решения на основе данных.

Независимо от того, расширяете ли вы или прекращаете использование определенных типов контента, использование информации из ваших данных позволяет вам адаптировать свою контентную стратегию в соответствии с предпочтениями вашей аудитории.

<стр>Метрики и анализ в контент-маркетинге предоставляют необходимые данные для создания контента, который находит отклик у вашей аудитории. <х3>Вариант использования 1. Определите запросы и страницы, которые приносят больше всего кликов

Для этого варианта использования вам нужны довольно простые данные.

Давайте всё это перечислим здесь:

<ул>

Следующий шаг — определить, из какой таблицы вы должны получить эту информацию. Помните, как мы обсуждали ранее, у вас есть:

<ул>

В этом случае вам нужны данные о производительности, агрегированные по URL-адресам, поэтому это означает использование таблицы searchdata_url_impression.

Сценарий №2: расчет UQC

Для этого варианта использования нам также нужно перечислить то, что нам нужно:

<ул>

<ли>Нам все еще нужно выбрать таблицу, в этом случае вам нужны данные о производительности, агрегированные по URL-адресам, поэтому это означает использование таблицы searchdata_url_impression.

Сценарий №3: Оценка риска контента

Чтобы рассчитать “вклад кликов 1% страниц с наибольшим количеством кликов” вам нужны следующие показатели:

<ул>

<х2>3. Запрос данных

Сценарий №1: Определите запросы и страницы, которые приносят больше всего кликов

Давайте свяжем всё это вместе, чтобы создать запрос, ладно?

Вы хотите видеть страницы с наибольшим количеством кликов и показов. Это простой код, который вы можете получить из справочника Марко Джордано по BigQuery, доступного в его информационном бюллетене.

Мы немного модифицировали его, чтобы удовлетворить наши потребности и обеспечить низкие затраты.

<п><сильный>Скопируйте этот запрос, чтобы получить страницы с наибольшим количеством кликов и показов:

ВЫБРАТЬ URL, SUM(клики) как общее_кликов, SUM(показы) как общее_импрессионное число FROM `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ search_type = 'WEB' и URL-адрес НЕ НРАВИТСЯ '%#%' И data_date = “13 февраля 2024 г.” ГРУППИРОВАТЬ ПО URL Упорядочить по общему числу кликов DESC;

Он основан на одном из наиболее распространенных шаблонов SQL. Он позволяет группировать по переменной, в нашем случае по URL-адресам. Затем вы можете выбрать нужные агрегированные показатели.

В нашем случае мы указали показы и клики, поэтому будем суммировать клики и показы (два столбца).

Давайте разберем запрос, которым поделился Марко:

оператор SELECT

SELECT url, SUM(клики) как total_clicks, SUM(impressions) как total_impressions: определяет столбцы, которые будут извлечены в наборе результатов.

<ул>

FROM пункт

<ул> <ли>FROM table_name`pragm-ga4.searchconsole.searchdata_url_impression`: Указывает таблицу, из которой извлекаются данные.

WHERE пункт

<ул>

<ли>search_type = ‘WEB’: гарантирует, что будут включены только данные, относящиеся к результатам веб-поиска.

Важно знать: мы рекомендуем выбрать за два дня до сегодняшней даты, чтобы гарантировать наличие данных.< /п>

Предложение GROUP BY

<ул>

<ли>При этом данные группируются таким образом, что функция СУММ подсчитывает общее количество кликов и показов для каждого уникального URL-адреса.

Условие ORDER BY

<ул>

<п>Этот запрос по-прежнему является более сложным, чем большинство новичков, поскольку он не только извлекает данные из нужной таблицы, но и фильтрует их на основе определенных условий (удаление привязок и типов поиска, которые не являются исключительно WEB).

После этого он подсчитывает общее количество кликов и показов для каждого URL-адреса, группирует результаты по URL-адресам и упорядочивает их на основе общего количества кликов в порядке убывания.

Вот почему вам следует сначала начать с варианта использования, затем выяснить метрики, а затем написать запрос.

Скопируйте этот SQL-код, чтобы получить запросы в GSC с наибольшим количеством кликов и показов:

<п>Запрос SELECT, SUM(клики) как общее количество кликов, SUM(показы) как общее количество показов FROM `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ search_type = 'ВЕБ' И data_date = “13 февраля 2024 г.” Запрос GROUP BY Упорядочить по общему числу кликов DESC;

Это тот же запрос, но вместо получения здесь URL-адреса мы получим запрос и агрегируем данные на основе этого поля. Вы можете увидеть это в части запроса GROUP BY.

Проблема этого запроса в том, что у вас, вероятно, будет много значений “null” результаты.результаты. Это анонимные запросы. Вы можете удалить их, используя этот запрос:

<п>Запрос SELECT, SUM(клики) как общее количество кликов, SUM(показы) как общее количество показов FROM `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ search_type = 'ВЕБ' И is_anonymized_query = ложь И data_date = “13 февраля 2024 г.” ГРУППИРОВАТЬ ПО ЗАПРОСУ Упорядочить по общему числу кликов DESC;

Теперь давайте сделаем еще один шаг. Мне нравится, как Ики Тай, SEO-специалист из GlobalShares, подошел к этому вопросу в LinkedIn. Во-первых, вам нужно определить, что делает запрос: вы можете увидеть наиболее эффективные URL-адреса по кликам за выбранный диапазон дат.

Запрос SQL должен получить данные из указанной таблицы, отфильтровать их по диапазону дат, а не по конкретной дате, вычислить общее количество показов и кликов для каждого URL-адреса, сгруппируйте результаты по URL-адресам и упорядочите их по общему количеству кликов в порядке убывания.

Теперь, когда это сделано, мы можем построить SQL-запрос:

<стр>ВЫБРАТЬ URL, СУММА(показы) КАК показов, СУММА(кликов) КАК кликов ОТ `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ data_date МЕЖДУ DATE_SUB(CURRENT_DATE(), ИНТЕРВАЛ 3 ДНЯ) И DATE_SUB(CURRENT_DATE(), ИНТЕРВАЛ 1 ДЕНЬ) ГРУППА ПО URL СОРТИРОВАТЬ ПО нажимает DESC; <стр>Прежде чем копировать и вставлять свой путь к славе, найдите время, чтобы понять, как это устроено:

оператор SELECT

<ул> <ли>ВЫБЕРИТЕ URL-адрес, СУММА (показы) AS показы, СУММА (клики) AS клики: определяет столбцы, которые будут извлечены в наборе результатов.

FROM пункт

<ул>

WHERE пункт

<ул> <ли>WHERE data_date BETWEEN DATE_SUB(CURRENT_DATE(), INTERVAL 3 DAY) AND DATE_SUB(CURRENT_DATE(), INTERVAL 1 DAY): фильтрует данные на основе диапазона дат.

<п><сильный>Важно знать: Как мы уже говорили ранее, у вас могут не быть данных за предыдущие два дня. Это означает, что вы можете изменить этот интервал, скажем, на пять и три дня вместо трех и одного дня.

Предложение GROUP BY

GROUP BY url: группирует результаты по столбцу URL.

<ул>

Условие ORDER BY

ORDER BY clicks DESC: определяет порядок набора результатов на основе столбца кликов в порядке убывания.

<ул>

Важное примечание: при первом запуске я рекомендую вам использовать LLM, например Gemini или ChatGPT, чтобы разбить запросы на фрагменты, которые вы сможете легко разбить. понимаю.

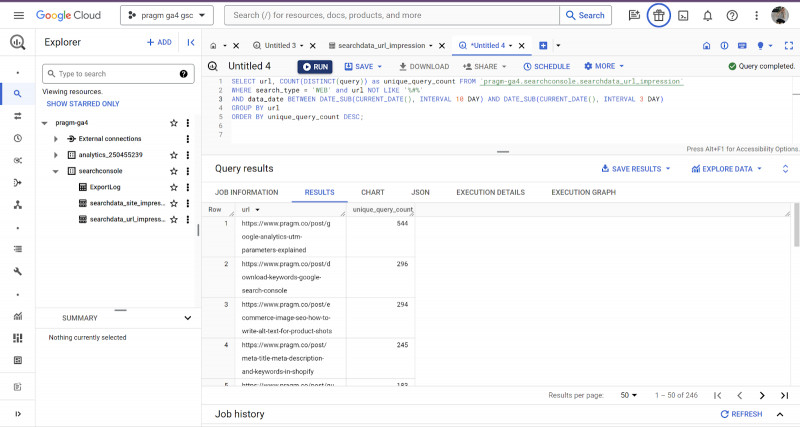

Сценарий №2: расчет UQC

<стр>Вот еще один полезный справочник Марко, который мы изменили, чтобы предоставить вам данные за семь дней (то есть за неделю): <п>ВЫБЕРИТЕ URL-адрес, COUNT(DISTINCT(query)) как unique_query_count FROM `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ search_type = 'WEB' и URL-адрес НЕ НРАВИТСЯ '%#%' И data_date МЕЖДУ DATE_SUB(CURRENT_DATE(), ИНТЕРВАЛ 10 ДНЕЙ) И DATE_SUB(CURRENT_DATE(), ИНТЕРВАЛ 3 ДНЯ) ГРУППИРОВАТЬ ПО URL ORDER BY unique_query_count DESC;

Снимок экрана из Google Cloud, февраль 2024 г.

На этот раз мы не будем разбивать запрос на части.

<п>Этот запрос вычисляет количество уникальных запросов (UQC) на страницу путем подсчета отдельных запросов, связанных с каждым URL-адресом, исключая URL-адреса, содержащие ‘#’ и фильтрация веб-поиска.

Это происходит с интервалом в семь дней, принимая во внимание, что данные за два предыдущих дня могут быть недоступны.

Затем результаты сортируются по количеству уникальных запросов в порядке убывания, что дает представление о том, какие страницы привлекают тот или иной диапазон поисковых запросов.

Сценарий №3: Оценка риска контента

Этот запрос вычисляет процент от общего количества кликов, приходящихся на 1% самых популярных URL-адресов с точки зрения кликов. Это гораздо более сложный запрос, чем предыдущие. Это взято прямо из Playbook Марко:

С PageClicksRanked AS ( ВЫБИРАТЬ URL, СУММА(клики) AS total_clicks, PERCENT_RANK() OVER (ORDER BY SUM (клики) DESC) AS процент_ранга ОТ `pragm-ga4.searchconsole.searchdata_url_impression` ГДЕ search_type = 'ВЕБ' И URL-адрес НЕ НРАВИТСЯ на '%#%' ГРУППА ПО URL ) ВЫБИРАТЬ ROUND(SUM(CASE WHEN period_rank <= 0,01 THEN total_clicks ELSE 0 END)/SUM(total_clicks) * 100, 2) КАК процент_кликов ОТ PageClicksРанговый; <п>Этот SQL-запрос более сложен, поскольку он включает в себя расширенные методы, такие как оконные функции, условное агрегирование и общие табличные выражения.

Давайте разберемся:

Общее табличное выражение (CTE) – Клики страниц с рейтингом

<ул>

<ли>PERCENT_RANK() OVER (ORDER BY SUM(clicks) DESC) AS period_rank: Вычисляет процентильный рейтинг для каждого URL-адреса на основе общего количества кликов, упорядоченных по убыванию.

<сильный>Условия

<ул>

<сильный>Группировка

<ул>

<п><сильный>Основной запрос

<ул>

Выбраны столбцы

<ул> <ли>ROUND(SUM(CASE WHEN процент_ранга <= 0,01 THEN total_clicks ELSE 0 END)/SUM(total_clicks) * 100, 2) AS процент_кликов: рассчитывает процент кликов, приходящихся на 1 % самых популярных URL-адресов. Оператор CASE отфильтровывает URL-адреса с процентильным рейтингом, меньшим или равным 0,01, а затем суммирует общее количество кликов для этих URL-адресов. Наконец, эта сумма делится на общую сумму кликов по всем URL-адресам и умножается на 100, чтобы получить процент. Функция ОКРУГЛ используется для округления результата до двух десятичных знаков.

<сильный>Источник

<ул>

(Голос диктора: вот почему мы не делимся более сложными запросами сразу. Написание сложных запросов сразу требует знаний, практики и понимания основных данных и бизнес-требований.)

Для написания таких запросов нужно:

<ул>

<ли>Глубокое понимание схемы базы данных, поэтому мы нашли время, чтобы рассмотреть их в другой статье.

<ли><сильный>Практика! Написание и оптимизация SQL-запросов помогает. То же самое можно сказать и о работе с наборами данных и решении аналитических задач! Практика означает использование итеративного подхода к экспериментированию, тестированию и уточнению запросов.

<х2>4. Создание информационных панелей Looker Studio

Как только это будет сделано, вы можете использовать Looker Studio для создания информационных панелей и визуализаций, демонстрирующих показатели эффективности вашего контента.

<стр>Вы можете настроить эти информационные панели для представления данных в осмысленном виде для различных заинтересованных сторон и команд. Это означает, что вы не единственный, кто имеет доступ к информации.

Мы углубимся в эту часть фреймворка в другой статье.

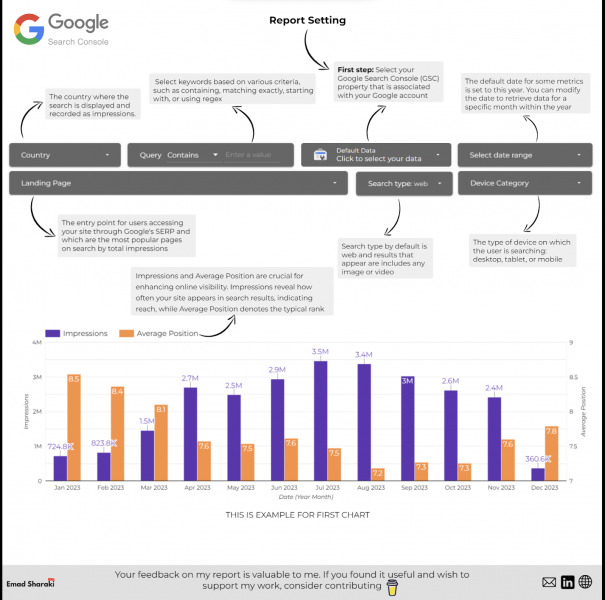

Однако, если вы хотите начать работу с информационной панелью Looker Studio, использующей данные BigQuery, Эмад Шараки поделился своей потрясающей информационной панелью. Рекомендуем попробовать.

Изображение Эмада Шараки, февраль 2024 г. <х2>5. Автоматизация отчетности

После того, как вы все это сделали, вы можете настроить запланированные запросы в BigQuery для автоматического получения данных GSC, присутствующих в таблицах, через регулярные промежутки времени.

Это означает, что вы можете автоматизировать создание и распространение отчетов внутри вашей компании.

Единственный совет, которым мы здесь поделимся, заключается в том, что вам следует планировать запросы после типичного окна экспорта, чтобы гарантировать, что вы запрашиваете самые последние доступные данные.

Чтобы отслеживать актуальность данных, вам следует отслеживать время завершения экспорта в журнале экспорта BigQuery.

<п>Вы можете использовать автоматизацию отчетности, чтобы помочь другим командам создавать и оптимизировать контент. Джанна Брачетти-Трускава, SEO-оптимизатор и стратег, поддерживает редакционные группы, интегрируя отчеты непосредственно в CMS.

Это означает, что редакторы могут фильтровать существующие статьи по производительности и соответствующим образом расставлять приоритеты в своих усилиях по оптимизации. Еще один элемент отчетности по автоматизации, который следует учитывать, — это интеграция с Jira для подключения вашей производительности к информационной панели с настраиваемыми правилами.

Это означает, что статьи можно переместить в начало списка невыполненных работ и что сезонные темы могут быть своевременно добавлены в список невыполненных работ, чтобы создать импульс.

<ч2>Идем дальше <стр>Очевидно, вам потребуется больше вариантов использования и более глубокое понимание типа аудита контента, который вы хотите провести.

Однако структура, о которой мы рассказали в этой статье, — отличный способ обеспечить структурированность вещей. Если вы хотите пойти дальше, Лазарина Стой, эксперт по SEO-данным, даст вам несколько советов:

<блоковая цитата><п>«При анализе эффективности контента важно понимать, что не весь контент создается одинаково. Используйте операторы SQL Case/When для создания подмножеств контента на основе типа страницы (страница компании, сообщение в блоге, тематическое исследование и т. д.), шаблонов структуры контента (объяснение концепции, новость, учебное пособие, руководство и т. д.), шаблонов заголовков. , целевое намерение, целевые аудитории, кластеры контента и любой другой тип классификации, уникальный для вашего контента.

Таким образом, вы сможете отслеживать и устранять неполадки, если обнаружите неэффективные шаблоны, а также активизировать усилия, которые окупаются, когда бы они ни были обнаружены.”

<стр>Если вы создаете запросы на основе этих соображений, поделитесь ими с нами, чтобы мы могли добавить их в кулинарную книгу запросов, которые можно использовать для анализа производительности контента! <ч2>Заключение <стр>Следуя этому структурированному подходу, вы можете эффективно использовать данные BigQuery и GSC для анализа и оптимизации производительности вашего контента, одновременно автоматизируя отчетность для информирования заинтересованных сторон.

Помните: сбор запросов других пользователей не сделает вас профессионалом BigQuery за одну ночь. Ваша ценность заключается в выяснении вариантов использования.

После этого вы можете определить нужные вам метрики и настроить запросы, созданные другими, или написать свои собственные. Как только это будет у вас в запасе, пришло время стать профессионалом и позволить другим использовать созданную вами панель мониторинга для визуализации ваших результатов. <стр>Ваше душевное спокойствие придет, как только вы автоматизируете некоторые из этих действий и еще больше разовьете свои навыки и запросы!